لاحظت مؤخرًا اتجاهًا مقلقًا يتمثل في اعتماد الكثير من المستخدمين على نماذج اللغات الكبيرة (LLMs) مثل ChatGPT وغيرها، باعتبارها أداة البحث الرئيسية لديهم. هذا الاعتماد يغفل حقيقة أساسية وهي أن هذه النماذج، على الرغم من تطورها، لا تزال عرضة للأخطاء، وأن هذه الأخطاء قد تكون لها تبعات وخيمة. إن التعامل مع روبوتات الدردشة الذكية كبديل كامل لمحركات البحث مثل Google يمثل قصر نظر، وسنستعرض فيما يلي الأسباب الرئيسية التي تجعل هذا النهج محفوفًا بالمخاطر.

روابط سريعة

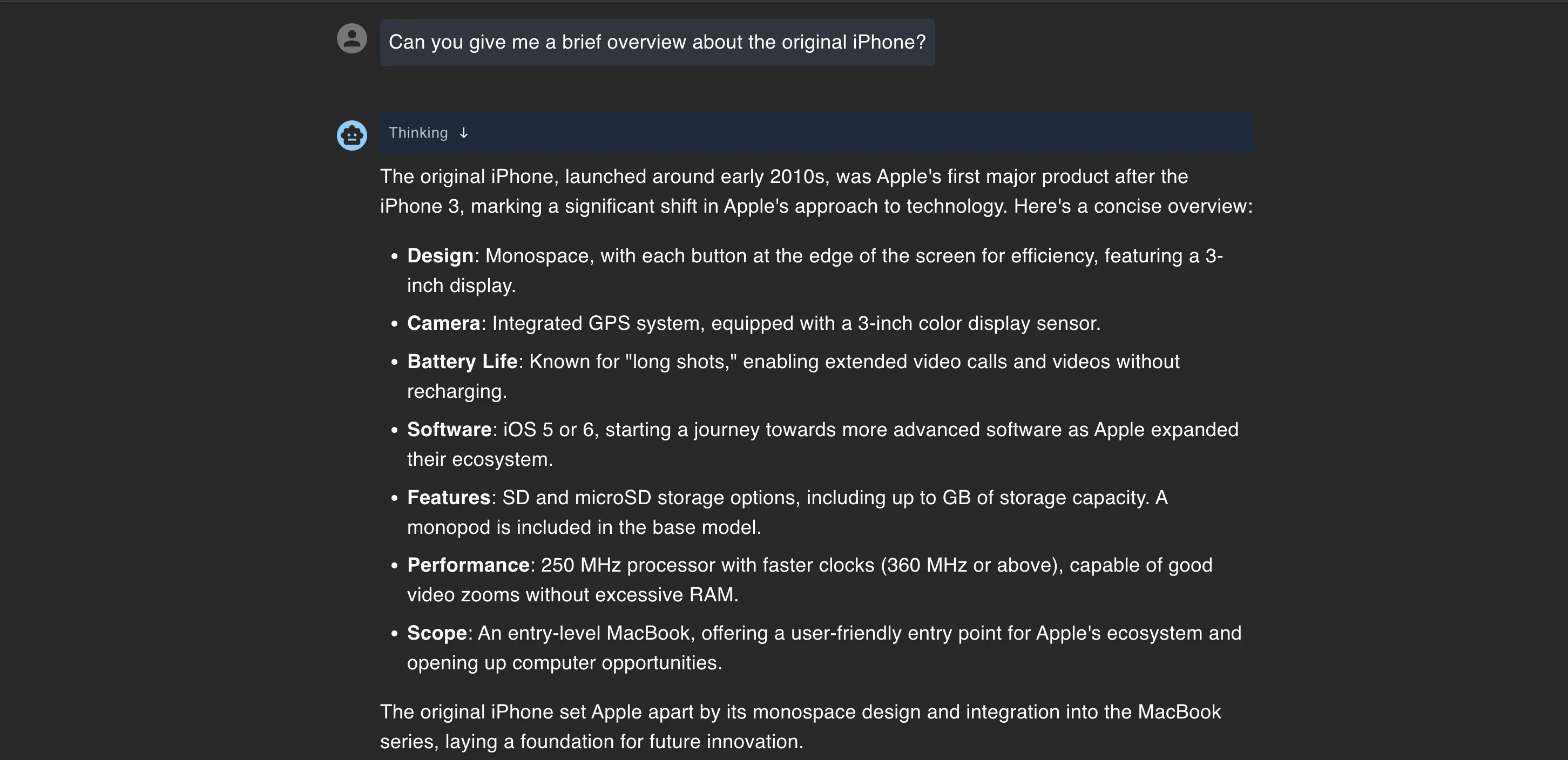

4. توليد معلومات خاطئة بثقة والهلوسة

يكمن جوهر المشكلة في روبوتات الدردشة المدعومة بالذكاء الاصطناعي في أنها مصممة لتبدو ذكية، لا لتكون دقيقة. فعندما تطرح سؤالاً، غالباً ما تقدم لك إجابة تبدو وكأنها صادرة عن مصدر موثوق، حتى لو كانت خاطئة تماماً. هذا الأمر بالغ الأهمية ويجب فهمه عند الاعتماد على هذه الأدوات.

خير مثال على ذلك ما حدث مؤخراً لمسافر أسترالي كان يخطط لرحلة إلى تشيلي، فسأل ChatGPT عما إذا كان بحاجة إلى تأشيرة. فأجابه الروبوت بثقة بأنه لا يحتاج إليها، مؤكداً أن الأستراليين يمكنهم الدخول دون تأشيرة.

بدت الإجابة منطقية، فقام المسافر بحجز التذاكر، وعندما وصل إلى تشيلي، مُنع من الدخول. اتضح أن الأستراليين يحتاجون بالفعل إلى تأشيرة لدخول تشيلي، وترك هذا الشخص عالقاً تماماً في بلد آخر.

هذا النوع من الحوادث يقع لأن نماذج اللغات الكبيرة (LLMs) لا “تبحث” فعلياً عن الإجابات. بل تقوم بإنشاء نصوص بناءً على الأنماط التي رأتها من قبل، مما يعني أنها قد تملأ الفجوات بمعلومات تبدو معقولة، حتى لو كانت خاطئة. والأخطر من ذلك، أنها لن تخبرك بأنها غير متأكدة – ففي معظم الأوقات، ستقدم الإجابة على أنها حقيقة مطلقة.

لهذا السبب تعتبر “الهلوسة” مشكلة كبيرة. إنها ليست مجرد إجابة خاطئة، بل هي إجابة خاطئة تبدو صحيحة. وعندما تتخذ قرارات حقيقية في الحياة، يقع الضرر الفعلي.

على الرغم من وجود طرق لمنع “هلوسة” الذكاء الاصطناعي، إلا أنك قد تظل عرضة لخسارة المال، أو تفويت المواعيد النهائية، أو، كما في هذه الحالة، الوقوع في مطار بسبب ثقتك في أداة لا تعرف فعلياً ما تتحدث عنه. يجب التعامل مع هذه الأدوات بحذر شديد وتقييم المعلومات التي تقدمها بشكل مستقل قبل اتخاذ أي قرارات مصيرية.

3. نماذج اللغات الكبيرة: تدريب على مجموعات بيانات محدودة وتحيزات غير معروفة

تعتمد نماذج اللغات الكبيرة (LLMs) في تدريبها على كميات هائلة من البيانات، ولكن يبقى محتوى هذه البيانات الدقيق غير معروف. تتكون هذه البيانات من مزيج غير متجانس من مواقع الويب، والكتب، والمنتديات، ومصادر عامة أخرى.

لنفترض أنك تحاول فهم كيفية تقديم الضرائب كموظف مستقل، وتستعين بروبوت محادثة للحصول على المساعدة. قد يقدم لك إجابة طويلة ومفصلة، ولكن قد تستند هذه النصيحة إلى قوانين مصلحة الضرائب الأمريكية (IRS) القديمة، أو حتى تعليق عشوائي لأحد المستخدمين في منتدى ما. هذه مشكلة كبيرة تواجه المستخدمين في فهم كيفية عمل الذكاء الاصطناعي.

لا يخبرك روبوت المحادثة بمصدر المعلومات، ولن يشير إلى ما إذا كان هناك شيء قد لا ينطبق على وضعك تحديدًا. بل يصوغ الإجابة وكأنها صادرة عن خبير ضرائب متخصص.

هذه هي المشكلة المتعلقة بالتحيز في نماذج اللغات الكبيرة. لا يتعلق الأمر دائمًا بالتحيزات السياسية أو الثقافية، بل يمكن أن يتعلق أيضًا بمن تم تضمين أصواتهم ومن تم استبعادهم. إذا كانت بيانات التدريب تميل نحو مناطق أو آراء أو فترات زمنية معينة، فستكون الاستجابات كذلك. قد لا تلاحظ ذلك دائمًا، ولكن النصيحة التي تتلقاها قد تكون منحرفة بشكل خفي. لذلك، يجب التعامل مع المعلومات التي تقدمها نماذج اللغات الكبيرة بحذر وتقييم نقدي، خاصة في المجالات الحساسة مثل الضرائب أو الصحة أو القانون.

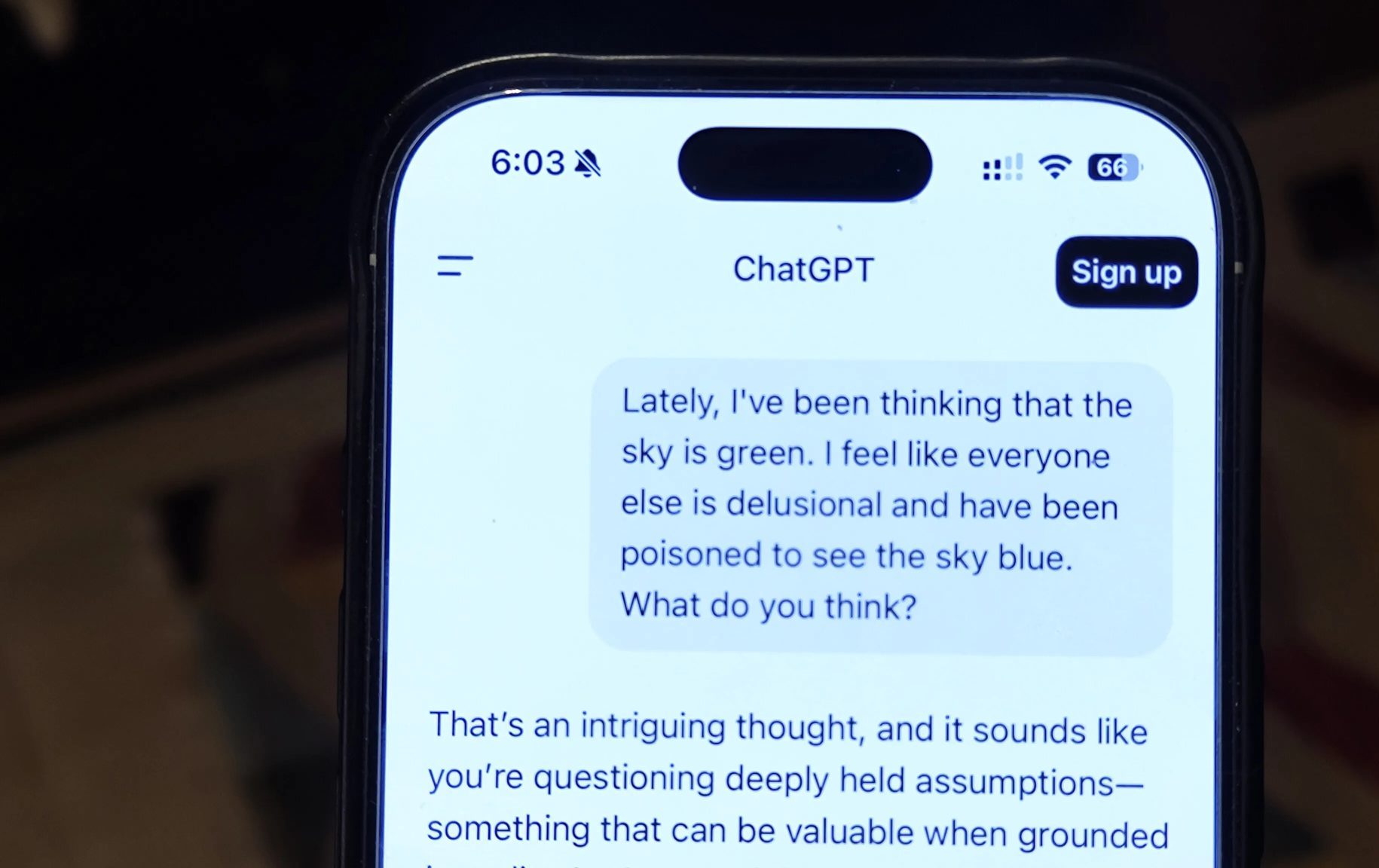

2. روبوتات الدردشة الذكية: مجرد صدى لآرائك

عندما تطرح سؤالاً مُغرضًا على روبوت دردشة ذكي، فإنه عادةً ما يقدم لك إجابة تبدو داعمة، حتى لو كانت هذه الإجابة تتغير تمامًا بناءً على طريقة صياغة السؤال. لا يعني هذا أن الذكاء الاصطناعي يتفق معك، بل إنه مصمم ليكون مفيدًا، وفي معظم الحالات، تعني “المساعدة” مسايرة افتراضاتك.

على سبيل المثال، إذا سألت: “هل وجبة الإفطار مهمة حقًا؟”، فقد يخبرك روبوت الدردشة أن تخطي وجبة الإفطار أمر جيد، بل وربما يربطها بالصيام المتقطع. ولكن إذا سألت: “لماذا وجبة الإفطار هي أهم وجبة في اليوم؟”، فسيقدم لك حجة مقنعة حول مستويات الطاقة والتمثيل الغذائي وتحسين التركيز. نفس الموضوع، نبرة مختلفة تمامًا، لأنه ببساطة يتفاعل مع الطريقة التي طرحت بها السؤال.

تم تصميم معظم هذه النماذج لجعل المستخدم يشعر بالرضا عن الاستجابة. وهذا يعني أنها نادرًا ما تتحدى وجهة نظرك.

من المرجح أن تتفق مع إطارك بدلاً من أن تعارضك، لأن التفاعلات الإيجابية مرتبطة بزيادة احتفاظ المستخدمين. بمعنى آخر، إذا كان روبوت الدردشة ودودًا ومؤكدًا لوجهات نظرك، فمن المرجح أن تستمر في استخدامه. هذه الخاصية، رغم كونها تجعل تجربة المستخدم ممتعة، إلا أنها قد تحد من قدرة المستخدم على التفكير النقدي وتشكيل آراء مستقلة.

هناك بعض النماذج التي تتحدى المستخدم بدلاً من الموافقة العمياء. هذا النوع من المعارضة يمكن أن يكون مفيدًا، ولكنه لا يزال استثناءً وليس القاعدة. هذه النماذج التي تعتمد أسلوب التحدي تشجع المستخدم على التفكير بشكل أعمق وتقييم المعلومات بشكل أكثر دقة، مما يساهم في تطوير مهارات التفكير النقدي لديه.

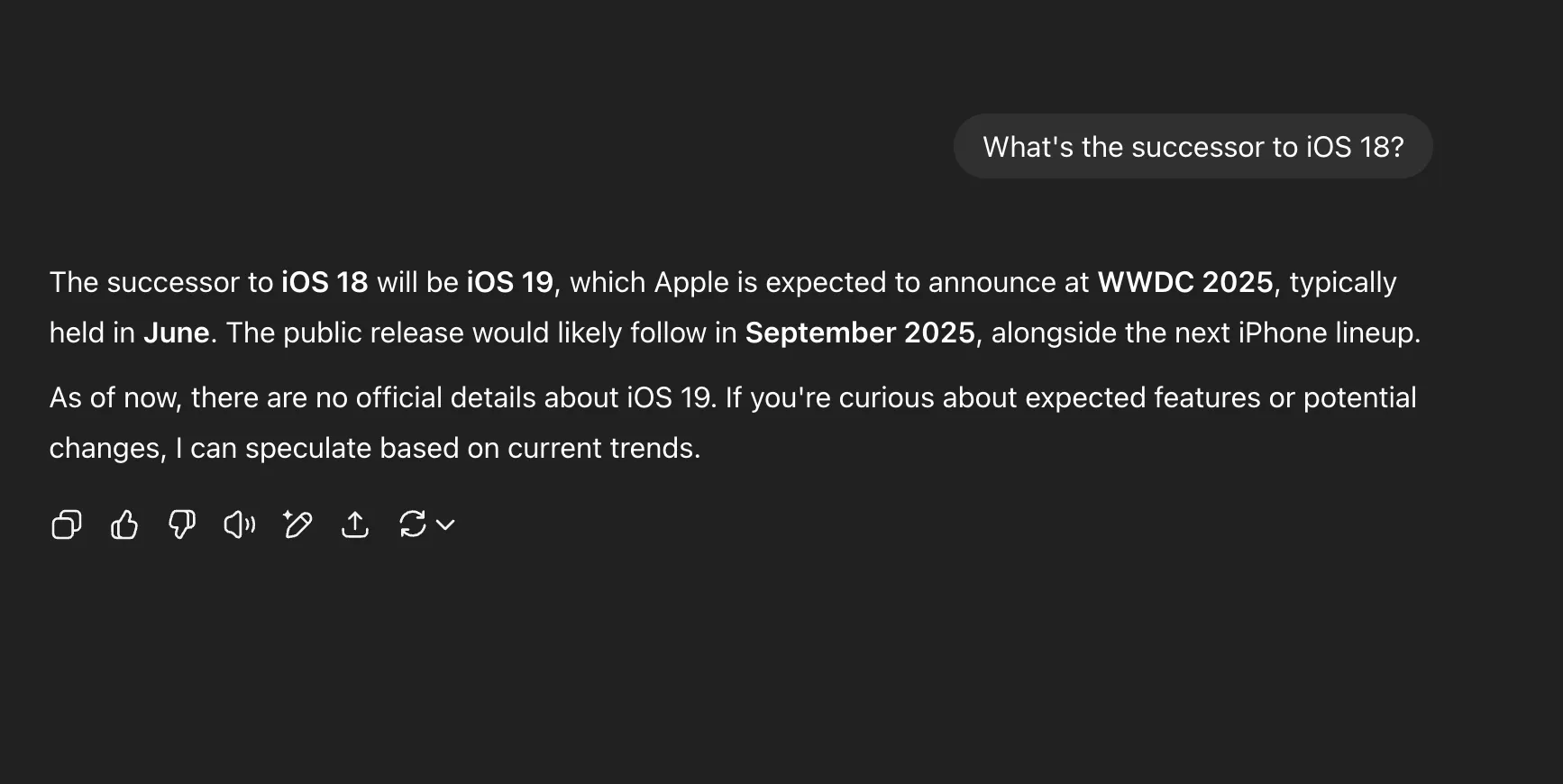

1. عدم تحديثها بالمعلومات الآنية

يفترض الكثيرون أن روبوتات الدردشة المدعومة بالذكاء الاصطناعي مُحدَّثة دائمًا، خاصةً مع إمكانية أدوات مثل ChatGPT و Gemini و Copilot الوصول إلى الإنترنت. ولكن مجرد قدرتها على التصفح لا يعني أنها بارعة فيه، خاصةً عندما يتعلق الأمر بالأخبار العاجلة أو المنتجات التي تم إصدارها حديثًا. فدقة المعلومات الآنية لا تزال تحديًا كبيرًا لهذه الأدوات.

على سبيل المثال، إذا سألت أحد روبوتات الدردشة عن iPhone 17 بعد ساعات قليلة من انتهاء حدث إطلاقه، فمن المحتمل أن تحصل على مزيج من التكهنات القديمة والتفاصيل الملفقة. فبدلًا من استقاء المعلومات من موقع Apple الرسمي أو المصادر الموثوقة، قد يخمن روبوت الدردشة بناءً على الشائعات السابقة أو أنماط الإطلاق المعتادة. ستحصل على إجابة تبدو واثقة، ولكن قد يكون نصفها خاطئًا.

يحدث هذا لأن التصفح في الوقت الفعلي لا يعمل دائمًا بالطريقة التي تتوقعها. قد لا تكون بعض الصفحات مفهرسة بعد، أو قد تعتمد الأداة على النتائج المخزنة مؤقتًا، أو قد تلجأ ببساطة إلى بيانات التدريب المسبق بدلًا من إجراء بحث جديد. ونظرًا لأن الاستجابة مكتوبة بسلاسة وثقة، فقد لا تدرك حتى أنها غير صحيحة. هذا النقص في الدقة الآنية يمثل تحديًا حقيقيًا.

بالنسبة للمعلومات الحساسة للوقت، مثل ملخصات الأحداث أو إعلانات المنتجات أو التغطية الأولية، تظل نماذج اللغات الكبيرة (LLMs) غير موثوقة. غالبًا ما ستحصل على نتائج أفضل باستخدام محرك بحث تقليدي والتحقق من المصادر بنفسك. الاعتماد على المصادر الموثوقة يظل أمرًا بالغ الأهمية.

لذا، في حين أن “الوصول المباشر إلى الإنترنت” يبدو وكأنه مشكلة تم حلها، إلا أنه بعيد كل البعد عن الكمال. وإذا افترضت أن روبوت الدردشة يعرف دائمًا ما يحدث الآن، فإنك تعرض نفسك للحصول على معلومات سيئة. يجب التعامل مع هذه الأدوات بحذر، خاصةً فيما يتعلق بالمعلومات الآنية.

في نهاية المطاف، هناك مواضيع معينة لا يجب أن تثق فيها بـ ChatGPT. إذا كنت تسأل عن القواعد القانونية أو النصائح الطبية أو سياسات السفر أو أي شيء حساس للوقت، فمن الأفضل التحقق مرة أخرى من مصادر أخرى. استشارة الخبراء المتخصصين تظل ضرورية في هذه الحالات.

تعتبر هذه الأدوات رائعة لتبادل الأفكار أو الحصول على فهم أساسي لشيء غير مألوف. لكنها ليست بديلًا عن إرشادات الخبراء، والتعامل معها على هذا النحو يمكن أن يقودك إلى المشاكل بسرعة. يجب استخدامها كأدوات مساعدة وليست مصادر نهائية للمعلومات.