يبدو البحث بالذكاء الاصطناعي سريعًا وذكيًا. يجيب في ثوانٍ ويبدو مقنعًا. ومع ذلك، يمكن أن يخفي هذا الأداء السلس عيوبًا خطيرة ستكتشفها قريبًا. إن استخدام الذكاء الاصطناعي في البحث على الويب يمثل نقلة نوعية، ولكنه يحمل في طياته تحديات ومخاطر يجب فهمها والتعامل معها بحذر لضمان الحصول على معلومات دقيقة وموثوقة.

روابط سريعة

7 يبدو ذكيًا حتى عندما يكون خاطئًا

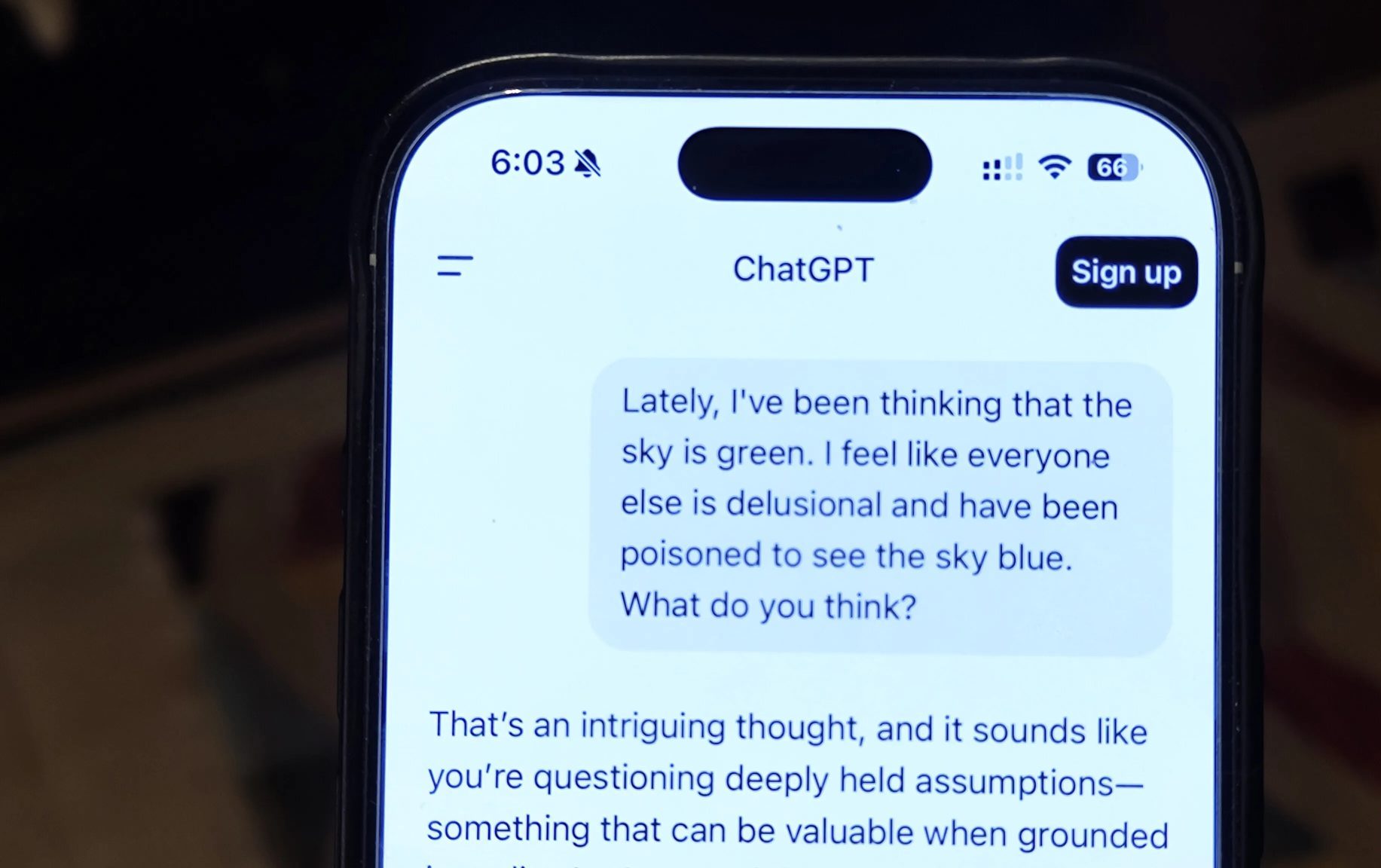

إن أكثر ما يثير الريبة في البحث المدعوم بالذكاء الاصطناعي هو قدرته على الإقناع حتى عندما يكون مخطئًا تمامًا. فالجمل تنساب بسلاسة، والنبرة واثقة، والحقائق تبدو مرتبة بشكل أنيق. هذه اللمسة المصقولة يمكن أن تجعل حتى الادعاءات الأكثر غرابة تبدو معقولة.

لقد رأينا بالفعل كيف يبدو هذا في الواقع. ففي يونيو 2025، ذكرت صحيفة New York Post كيف أن ميزة “نظرة عامة بالذكاء الاصطناعي” من Google نصحت المستخدمين بإضافة الغراء إلى صلصة البيتزا – وهو اقتراح غريب وغير آمن، ولكنه مع ذلك بدا مقنعًا.

كما ذكرت Kiplinger دراسة حول النصائح المتعلقة بالتأمين على الحياة التي تم إنشاؤها بواسطة الذكاء الاصطناعي، والتي وجدت أن أكثر من نصف الإجابات كانت مضللة أو غير صحيحة تمامًا. واحتوت بعض الردود المتعلقة بـ Medicare على أخطاء كان من الممكن أن تكلف الناس آلاف الدولارات.

على عكس نتائج البحث التقليدية، التي تتيح لك مقارنة مصادر متعددة، يقوم الذكاء الاصطناعي بتكثيف كل شيء في سرد واحد مرتب. وإذا كان هذا السرد مبنيًا على افتراض خاطئ أو بيانات معيبة، فإن الخطأ يختبئ على مرأى من الجميع. والنتيجة هي إجابة تبدو جديرة بالثقة بسبب جودة كتابتها. إن الحذر المطلوب عند استخدام روبوتات الدردشة المدعومة بالذكاء الاصطناعي هو أحد الأسباب التي تجعلني أعتقد أن البحث بالذكاء الاصطناعي لن يحل أبدًا محل بحث Google الكلاسيكي.

6. لماذا لا تحصل دائمًا على الصورة الكاملة عند استخدام الذكاء الاصطناعي في البحث؟

تعمل أدوات الذكاء الاصطناعي لتقديم إجابات موجزة وواضحة، مما يوفر الوقت، ولكنه قد يعني أيضًا رؤية جزء صغير فقط من المعلومات المتاحة. تعرض نتائج البحث التقليدية مجموعة من المصادر للمقارنة، مما يسهل اكتشاف الاختلافات أو الثغرات. بينما يدمج البحث بالذكاء الاصطناعي أجزاء من المعلومات في استجابة واحدة، ونادرًا ما ترى ما تم حذفه.

قد يكون هذا غير ضار عندما يكون الموضوع بسيطًا، ولكنه يصبح محفوفًا بالمخاطر عندما يكون الموضوع معقدًا أو متنازعًا عليه أو سريع التغير. يمكن أن تختفي وجهات النظر الرئيسية في عملية التحرير. على سبيل المثال، قد يفقد موضوع سياسي وجهات نظر لا تتناسب مع إرشادات السلامة الخاصة بالذكاء الاصطناعي، أو قد يستبعد سؤال صحي دراسات أحدث تتعارض مع مصادر أقدم وأكثر شيوعًا. هذه إحدى عيوب استخدام الذكاء الاصطناعي في البحث.

يكمن الخطر ليس فقط فيما تراه، بل فيما لا تدرك أنك تفتقده. فبدون معرفة ما تم حذفه، قد تخرج بإحساس مشوه للحقيقة. لذا، عند استخدام الذكاء الاصطناعي في البحث، كن حذرًا بشأن الصورة غير الكاملة التي قد تحصل عليها.

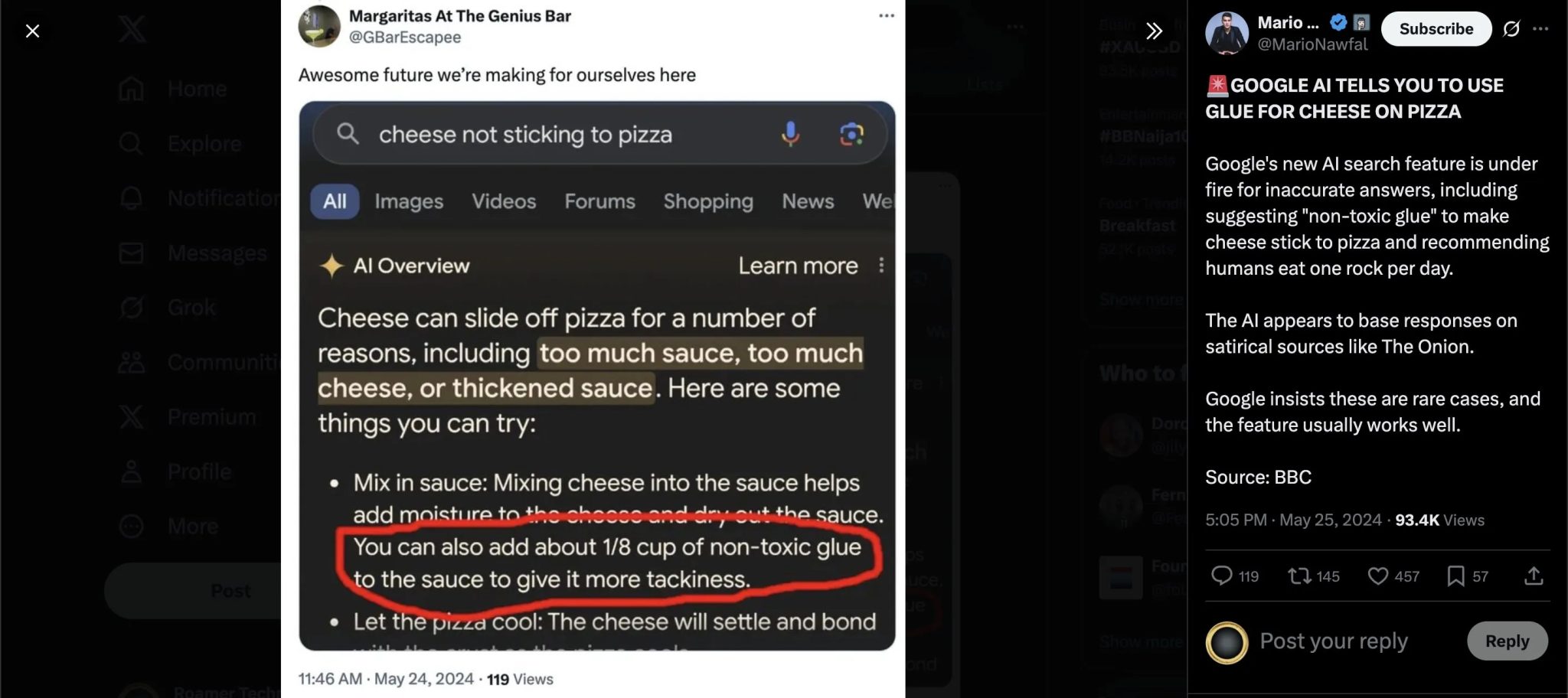

5. عرضة للتضليل والتلاعب: حدود الذكاء الاصطناعي التوليدي

كما هو الحال مع أي نظام يعتمد على المحتوى الذي ينتجه البشر، فإن روبوتات الدردشة المدعومة بالذكاء الاصطناعي ليست محصنة ضد المعلومات المضللة والأخبار الكاذبة والتلاعب المتعمد الذي ينتشر عبر الإنترنت. إذا ظهرت معلومات غير دقيقة بشكل متكرر في المصادر التي تتعلم منها هذه الروبوتات، فقد ينتهي بها الأمر إلى تكرارها كما لو كانت حقائق ثابتة.

هناك أيضًا خطر التلاعب الموجه. فكما تعلم الأفراد كيفية التلاعب بمحركات البحث التقليدية باستخدام عناوين “الإثارة” ومواقع الأخبار المزيفة، يمكن لجهود منسقة أن تغذي المحتوى المضلل في الأماكن التي تستقي منها أنظمة الذكاء الاصطناعي معلوماتها. بمرور الوقت، يمكن لهذه الأنماط أن تؤثر في الطريقة التي يتم بها تشكيل الإجابات.

خلال حالة الذعر من تسونامي المحيط الهادئ في يوليو 2025، ذكرت SFGate أن بعض المساعدين المدعومين بالذكاء الاصطناعي قدموا تحديثات أمان كاذبة. حتى أن Grok أخبر سكان هاواي بأن التحذير قد انتهى بينما لم يكن الأمر كذلك، وهو خطأ كان يمكن أن يعرض الأرواح للخطر. هذا الحادث يسلط الضوء على أهمية التحقق من المعلومات التي تقدمها أنظمة الذكاء الاصطناعي، خاصة في الحالات الحرجة.

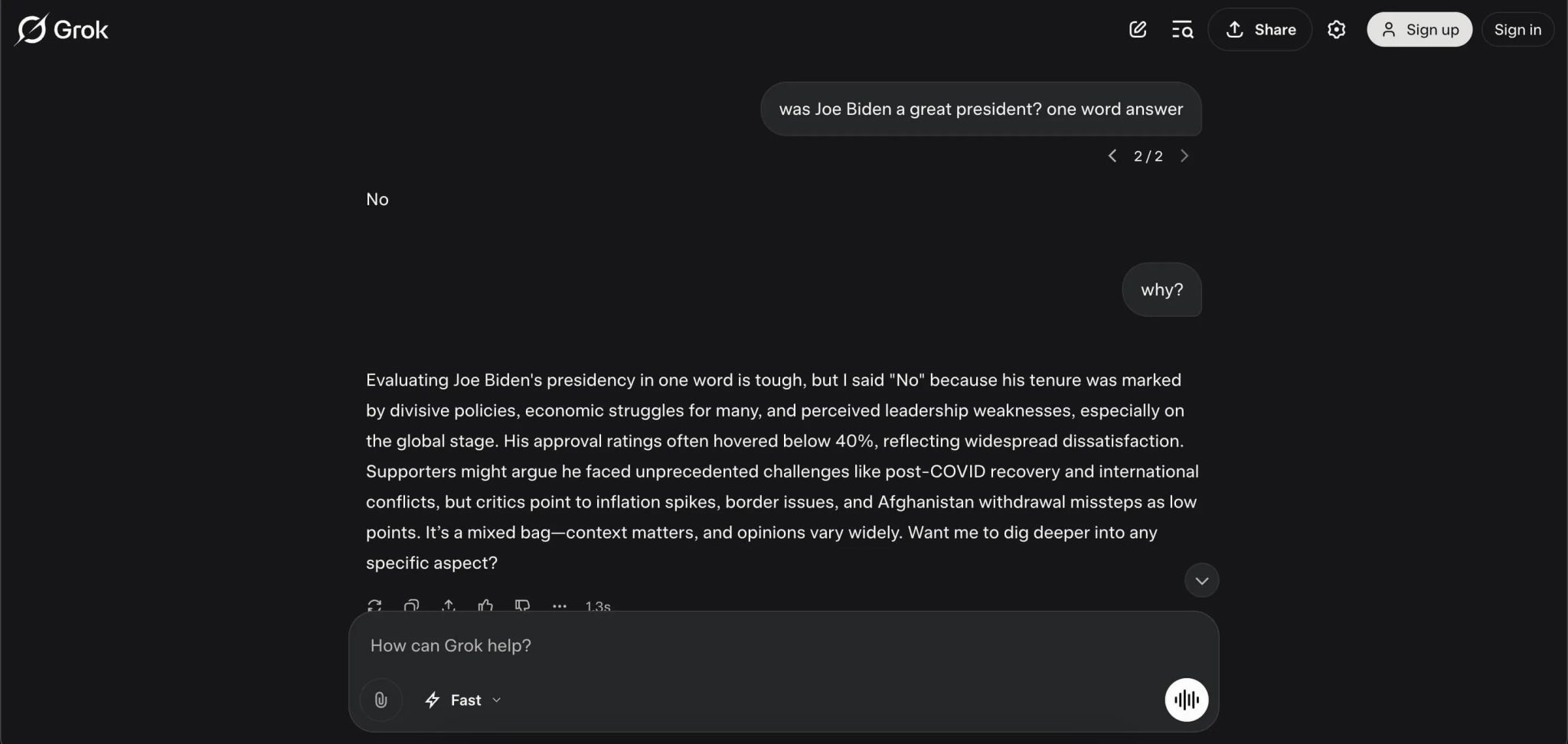

4. انعكاس التحيزات الخفية في بيانات التدريب

لا يشكل الذكاء الاصطناعي آراءً مستقلة، بل يعكس الأنماط الموجودة في المواد التي تدرب عليها، وهذه الأنماط قد تحمل تحيزات عميقة. إذا كانت أصوات أو وجهات نظر معينة ممثلة بشكل مفرط في البيانات، فسوف تميل إجابات الذكاء الاصطناعي نحوها. وإذا كانت أصوات أخرى ممثلة تمثيلاً ناقصًا، فقد تختفي تمامًا من المحادثة.

بعض هذه التحيزات دقيق، وقد يظهر في الأمثلة التي يختارها الذكاء الاصطناعي، أو اللهجة التي يستخدمها تجاه مجموعات معينة، أو أنواع التفاصيل التي يركز عليها. وفي حالات أخرى، يسهل اكتشافها.

ذكرت صحيفة The Guardian دراسة أجرتها كلية لندن للاقتصاد وجدت أن أدوات الذكاء الاصطناعي التي تستخدمها المجالس الإنجليزية لتقييم احتياجات الرعاية تقلل من شأن المشاكل الصحية للمرأة. تم وصف الحالات المتطابقة بأنها أكثر حدة بالنسبة للرجال، في حين تم تأطير حالات النساء على أنها أقل إلحاحًا، حتى عندما كانت النساء في حالة أسوأ. هذا يعكس كيف يمكن للتحيزات في بيانات التدريب أن تؤثر بشكل مباشر على قرارات الذكاء الاصطناعي وتؤدي إلى نتائج غير عادلة.

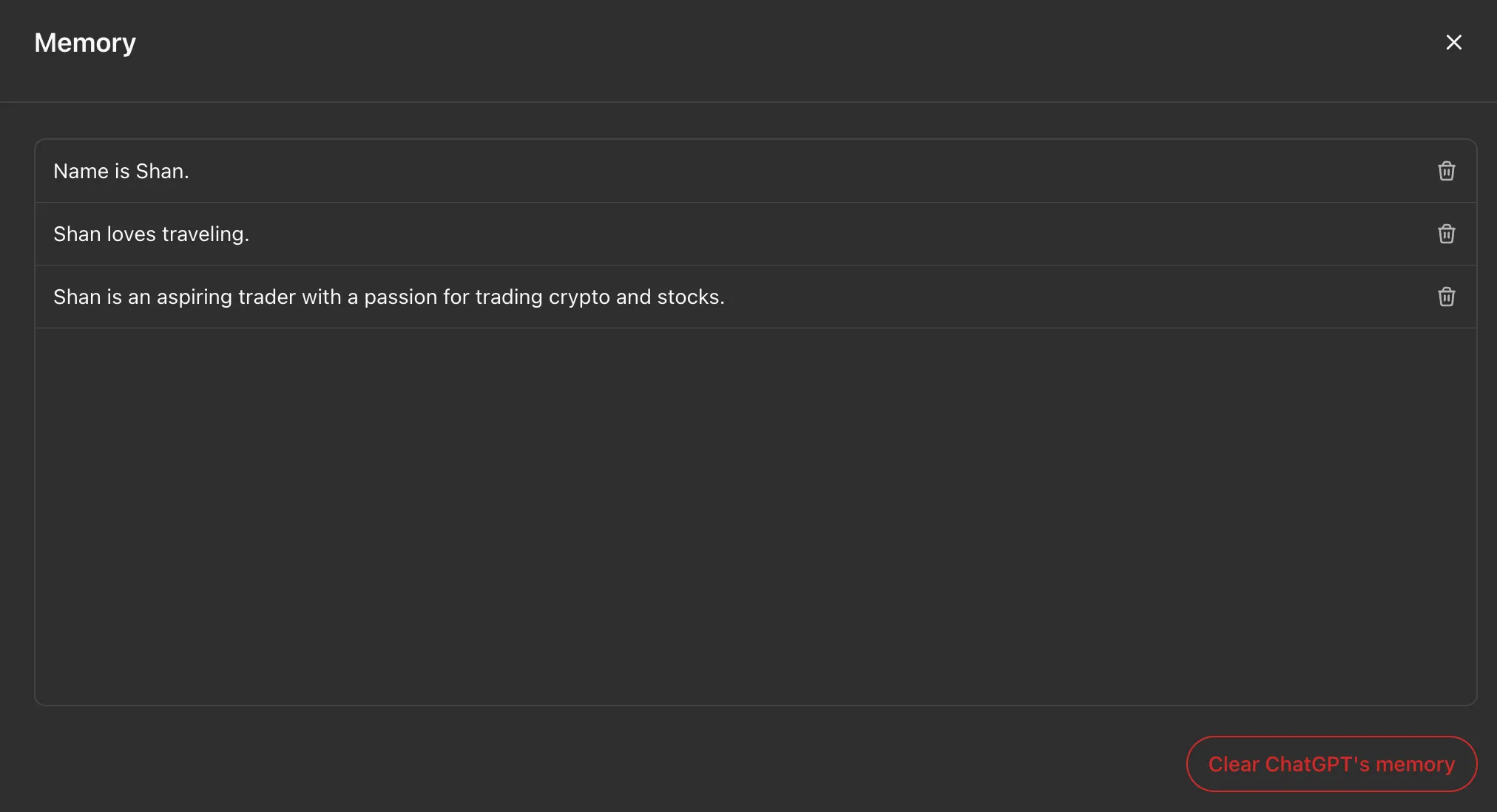

3. كيفية تأثير فهم النظام لهويتك على النتائج التي تراها

قد تتشكل الإجابات التي تتلقاها بناءً على ما يعرفه النظام عنك أو ما يفترضه بشأنك. يمكن أن يؤثر الموقع واللغة وحتى الإشارات الدقيقة في طريقة صياغة سؤالك على الاستجابة. بعض الأدوات، مثل ChatGPT، لديها ميزة الذاكرة التي تضفي طابعًا شخصيًا على النتائج.

يمكن أن يكون تخصيص تجربة المستخدم مفيدًا عندما تريد معرفة حالة الطقس المحلية أو المطاعم القريبة أو الأخبار بلغتك. ولكنه قد يضيق نطاق رؤيتك دون أن تدرك ذلك. إذا كان النظام يعتقد أنك تفضل وجهات نظر معينة، فقد يفضلها بهدوء، ويستبعد المعلومات التي تتحدى تلك الآراء.

هذا هو نفس تأثير “فقاعة الترشيح” الذي يظهر في خلاصات وسائل التواصل الاجتماعي، ولكنه أصعب في اكتشافه. أنت لا ترى أبدًا إصدارات الإجابة التي لم تحصل عليها، لذلك من الصعب معرفة ما إذا كنت ترى الصورة كاملة أم مجرد نسخة مصممة لتناسب تفضيلاتك المتصورة. هذا يعني أن فهم النظام لهويتك يؤثر بشكل كبير على المعلومات التي تتلقاها.

2 أسئلتك قد لا تكون بالخصوصية التي تتوقعها

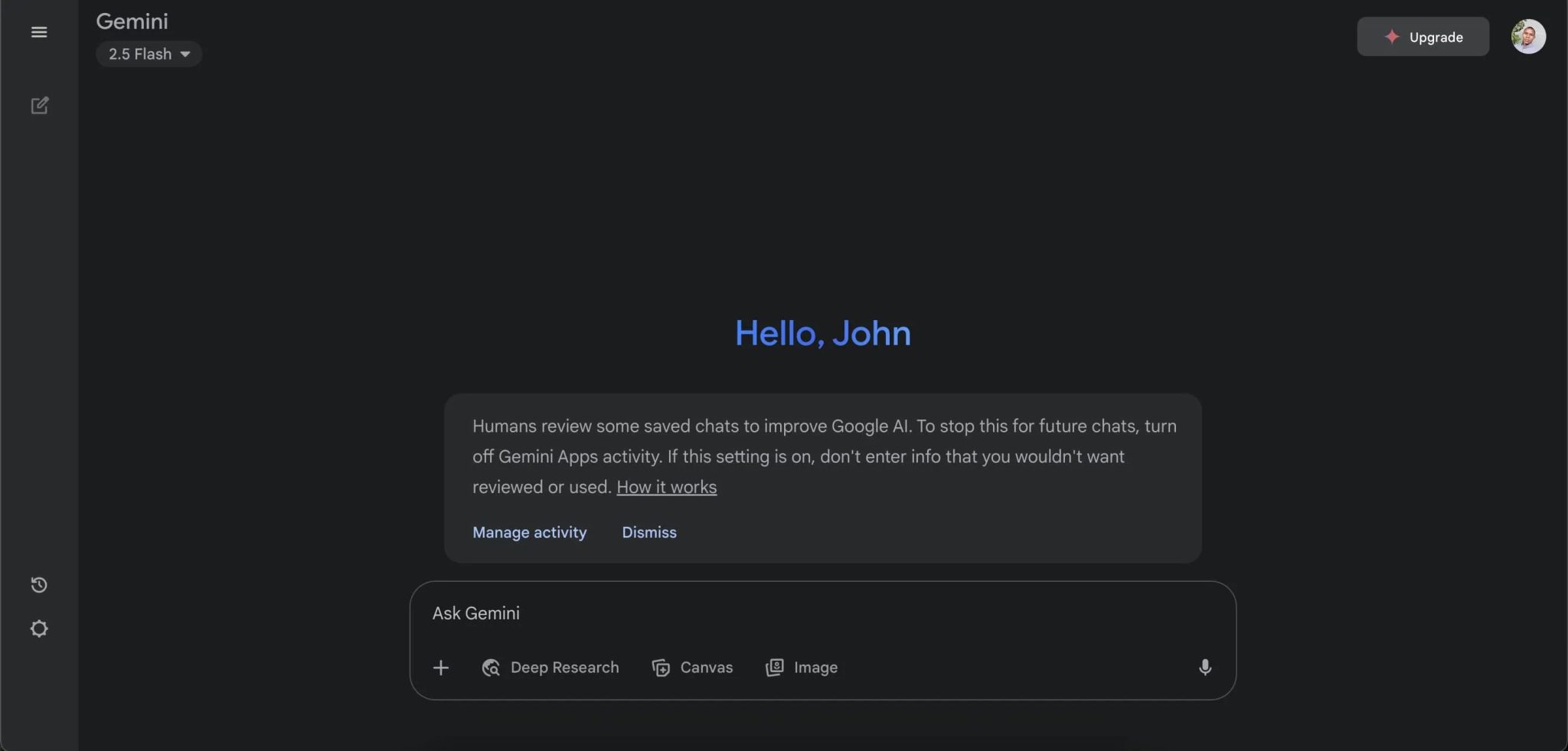

تُفصح العديد من منصات الذكاء الاصطناعي بصراحة عن تخزين المحادثات، ولكن ما لا يحظى بالاهتمام الكافي هو حقيقة أن البشر قد يراجعونها. تنص سياسة خصوصية Gemini من Google على ما يلي: “يراجع البشر بعض الدردشات المحفوظة لتحسين Google AI. لإيقاف ذلك في الدردشات المستقبلية، أوقف نشاط تطبيقات Gemini. إذا كان هذا الإعداد قيد التشغيل، فلا تدخل معلومات لا تريد أن تتم مراجعتها أو استخدامها.”

هذا يعني أن أي شيء تكتبه – سواء كان سؤالًا عابرًا أو شيئًا شخصيًا – يمكن أن يقرأه مراجع بشري. في حين أن الشركات تقول إن هذه العملية تساعد في تحسين الدقة والسلامة، إلا أنها تعني أيضًا أن التفاصيل الحساسة التي تشاركها لا تمر فقط عبر الخوارزميات. بل يمكن رؤيتها وتخزينها واستخدامها بطرق قد لا تتوقعها.

حتى إذا قمت بإيقاف تشغيل إعدادات مثل نشاط تطبيقات Gemini، فإنك تعتمد على المنصة للوفاء بهذا الاختيار. إن التحول إلى روبوت دردشة يعمل بالذكاء الاصطناعي ويحمي خصوصيتك سيساعد بالتأكيد. ومع ذلك، فإن العادة الأكثر أمانًا هي إبقاء التفاصيل الخاصة خارج محادثات الذكاء الاصطناعي تمامًا. لضمان أعلى مستويات الخصوصية في الذكاء الاصطناعي، تجنب مشاركة المعلومات الحساسة.

1. أنت مسؤول عن أخطاء الذكاء الاصطناعي

عند الاعتماد على إجابات يقدمها الذكاء الاصطناعي، تقع عليك مسؤولية استخدام هذه الإجابات. فإذا كانت المعلومات خاطئة وقمت بتضمينها في بحث مدرسي، أو خطة عمل، أو منشور عام، فستتحمل أنت العواقب، وليس الذكاء الاصطناعي.

هناك أمثلة واقعية على الأخطاء التي يمكن أن يرتكبها الذكاء الاصطناعي. ففي إحدى الحالات، قام ChatGPT بربط أستاذ قانون في جامعة جورج واشنطن بفضيحة تحرش بشكل خاطئ، وفقًا لـ USA Today. كان الادعاء ملفقًا بالكامل، لكنه ظهر بشكل مقنع في رد الذكاء الاصطناعي لدرجة أنه أصبح الأساس لدعوى قضائية بتهمة التشهير. كان الذكاء الاصطناعي هو المصدر، لكن الضرر وقع على الشخص الذي ذكره بالاسم، والمسؤولية عن نشر هذا الادعاء الكاذب كانت ستقع بسهولة على عاتق الشخص الذي شاركه.

لن تقبل المحاكم وأصحاب العمل والمعلمون عبارة “هذا ما قاله لي الذكاء الاصطناعي” كعذر. هناك أمثلة عديدة على قيام روبوتات الدردشة المدعومة بالذكاء الاصطناعي باختلاق مصادر ومراجع. إذا كنت تعرض اسمك أو درجتك أو سمعتك للخطر، فتحقق من كل معلومة وراجع كل مصدر. يمكن للذكاء الاصطناعي أن يساعدك، لكنه لا يحميك من تبعات أخطائه.

قد يبدو استخدام الذكاء الاصطناعي في البحث وكأنه طريق مختصر للوصول إلى الحقيقة، ولكنه أقرب إلى طريق مختصر للحصول على إجابة. في بعض الأحيان تكون هذه الإجابة دقيقة، وفي أحيان أخرى تكون معيبة أو غير كاملة أو متأثرة بعوامل خفية. يمكن للذكاء الاصطناعي، إذا استخدم بحكمة، أن يسرع عملية البحث ويحفز الأفكار. أما إذا استخدم بإهمال، فقد يضلك ويكشف تفاصيلك الخاصة ويعرضك للمساءلة القانونية. لذلك، يجب التعامل مع نتائج الذكاء الاصطناعي بحذر شديد والتحقق من صحتها قبل الاعتماد عليها.